2023年2月至8月,作为文档图像分析领域最重要的国际会议之一,国际文档分析与识别会议International Conference on Document Analysis and Recognition(简称ICDAR)联合全球权威学术机构和众多知名企业,共同举办了多项挑战赛,吸引了来自AI相关研究团队的广泛参与。继2018年参与多项图文识别竞赛(ICPR 2018文字识别与检测/遥感图像检测竞赛、ICFHR 2018手稿分析竞赛、ICDAR 2019手写数学公式识别竞赛、ICFHR 2020数学公式识别竞赛……)并夺冠后,中科大语音及语言信息处理国家工程研究中心(NERC-SLIP)杜俊副教授带领团队联合科大讯飞研究院(以下简称“NERCSLIP联合团队”)再接再厉,在今年的赛事中尝试各种不同的方法和策略,以应对复杂的图文信息处理的挑战,最终在文档信息定位与提取比赛(DocILE)中获得全部两个赛道的第一,在票证结构化信息抽取任务(SVRD)零样本赛道中获得第一,并于CLEF 2023会议上获评DocILE赛道的最佳竞赛论文。

NERCSLIP联合团队成员

DocILE之冠:“行里挑一”,文档信息定位与提取比赛双赛道登顶榜首并获最佳竞赛论文

DocILE竞赛由文档智能化企业Rossum.ai联合法国拉罗谢尔大学、捷克科技大学、西班牙计算视觉中心共同举办,并在ICDAR 2023以及CLEF 2023(International Conference of the CLEF Association)上联合发布,旨在评估机器学习方法在半结构化的商业文档中,对关键信息定位、提取和行项识别的性能。该赛事分为KILE和LIR两个赛道任务,KILE任务需要定位文档中预定义类别的关键信息位置,LIR任务需要在前者基础上,进一步将每个关键信息分组为不同的行项条目(Line Item),比如表格中某一行单个对象(数量、价格)等。经过近五个月的努力,NERCSLIP联合团队最终收获双赛道冠军。

KILE赛道获奖证书

LIR赛道获奖证书

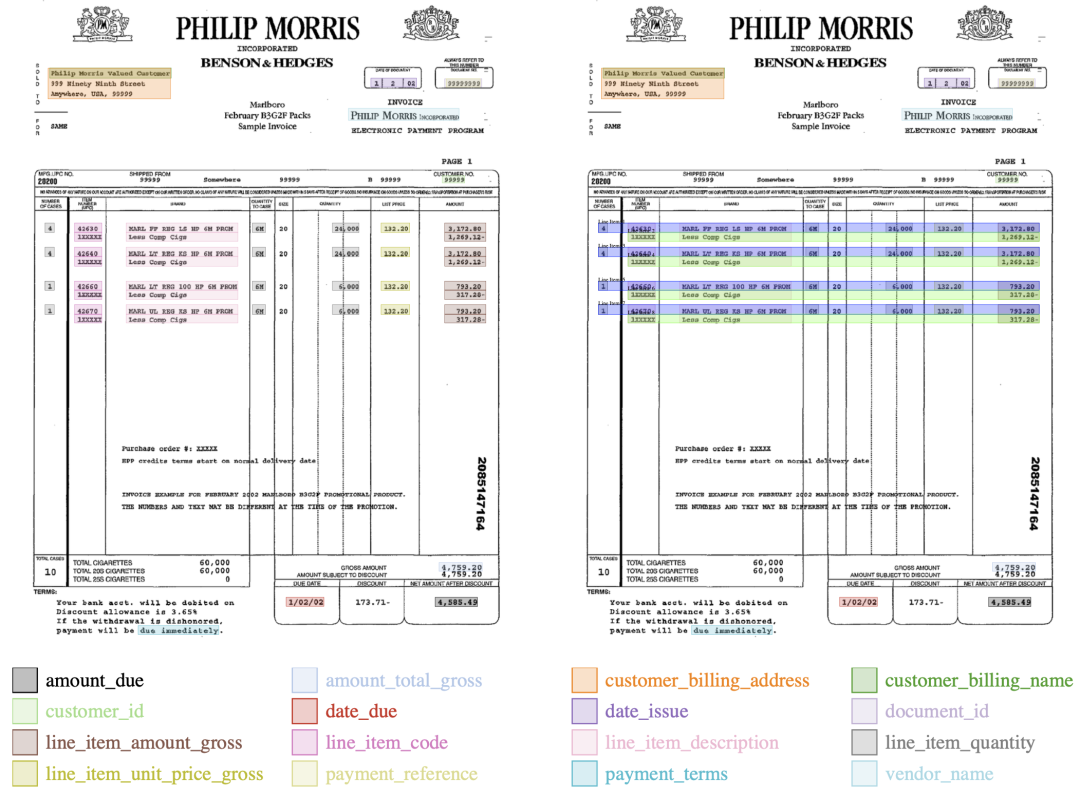

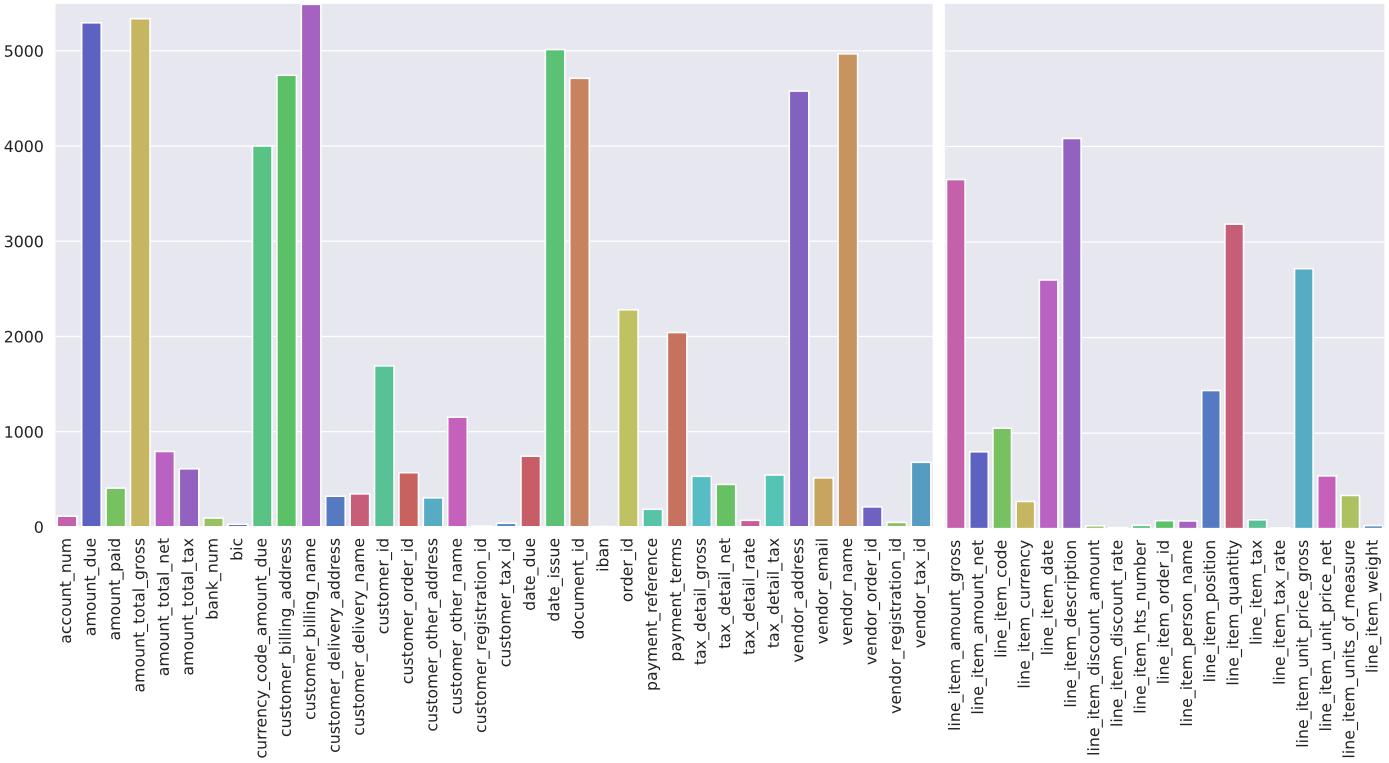

不同于以往的学术竞赛,此次DocILE竞赛中待抽取的信息种类非常繁杂,且存在较为严重的类别不均衡问题。其中,KILE任务不仅需要提取预定义类别的关键信息,还要得到关键信息的具体位置;LIR任务中,一个行项在单个表格中可能有多行文本。加上此次赛事数据集文档数量多、文档版式复杂多样,大大增加了赛事的挑战性。

左为KILE赛道说明,右为LIR赛道说明

不同种类要素在训练/验证集中出现的频次

显著优势背后:

多项关键技术创新提升模型能力

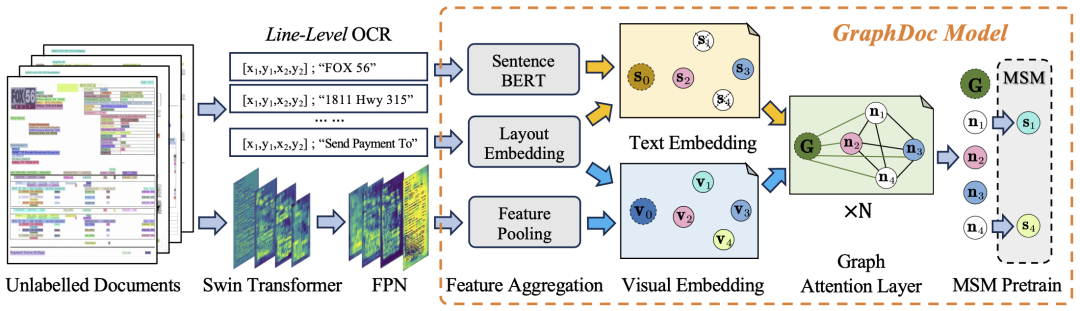

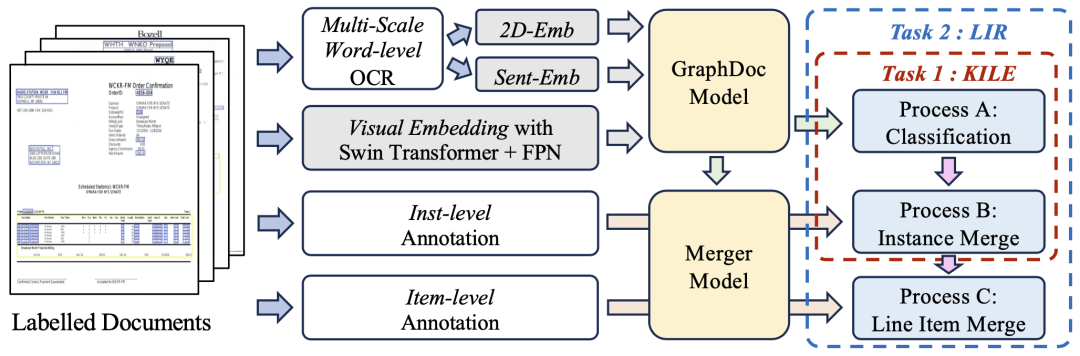

在本次赛事中,NERCSLIP联合团队在预训练阶段设计了基于OCR质量的文档过滤器,从主办方提供的无标注文档中提取出274万页的文档图像,随后通过预训练语言模型获取文档中各文本行的语义表征,并采用掩码语句表征恢复任务进行不同Top-K(GraphDoc模型中关于文档注意力范围的一个超参数)配置下的预训练。

在数据集微调阶段,NERCSLIP联合团队使用了预训练后的GraphDoc提取文本框的多模态表征,并进行分类操作。在分类结果的基础上,将多模态表征送入低层注意力融合模块进行实例的聚合,在实例聚集的基础上,使用高层注意力融合模块实现行项实例的聚集,所提出的注意力融合模块结构相同、但彼此不共享参数,可以同时用于KILE和LIR任务且具有很好的效果。

完美收尾:

精心打磨细节终获最佳竞赛论文

DocILE竞赛同时依托ICDAR 2023以及CLEF 2023两个国际学术会议开展,此次竞赛委员会选择在希腊举办的CLEF 2023会议上,综合各队伍提交的最终成绩、技术方案和现场展示等方面,最终评选出最佳竞赛论文。经过精心准备与排练,研究中心杜俊副教授的博士生马洁锋代表团队前往希腊参与竞争最佳竞赛论文。

前往希腊参加CLEF 2023会议

经过竞赛委员会的评选与讨论,NERCSLIP联合团队最终获得了DocILE赛道的最佳论文奖。

竞赛组委会为NERCSLIP团队颁发最佳论文奖

SVRD之冠:零样本票证结构化信息抽取任务第一,预训练模型大考验

SVRD(结构化文本信息抽取)竞赛由华中科技大学、百度、哈尔滨工业大学和中国科学院自动化研究所联合举办。本赛事包含HUST-CELL和BAIDU-FEST两大赛道,分别支撑复杂文档的结构化信息抽取和零样本/小样本条件下的结构化信息抽取。NERCSLIP联合团队在难度颇高的零样本结构化信息抽取子赛道(Task3:E2E Zero-shot Structured Text Extraction)获得第一。

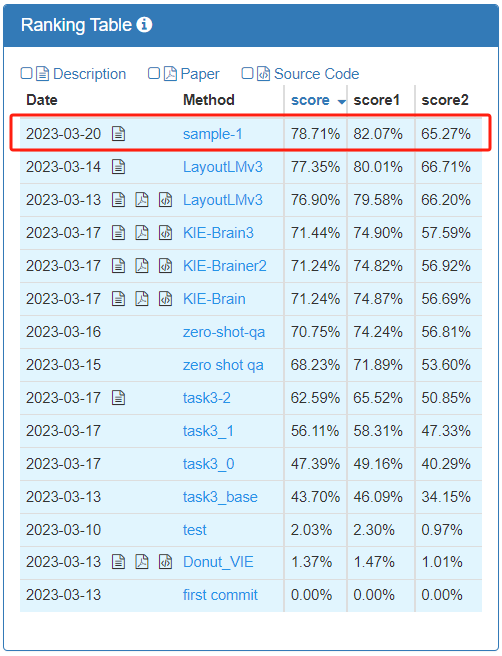

榜单排名

赛道获奖证书

在官方指定不同类型发票需要提取的关键要素背景下,该赛道要求参赛团队利用模型输出这些关键要素在图片中的对应内容,“零样本”则代表训练集和测试集的发票类型并无交集;赛道考查模型端到端预测准确率,取score1、score2加权平均值作为最终评价指标。

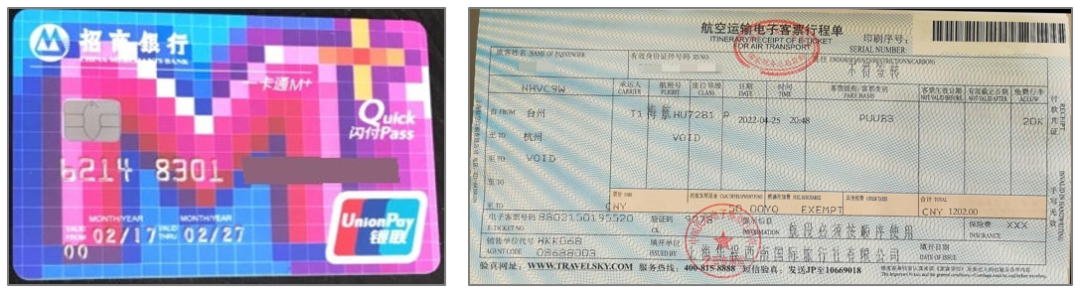

零样本对预训练模型能力提出了更高要求。同时,比赛使用的发票版式多样,乘车站点、发车时间等要素在不同版式中的名称各不相同,发票照片还存在背景干扰、反光、文字重叠等问题,进一步提升了识别和抽取难度。

不同版式的发票

条纹背景干扰的发票

团队首先对要素抽取模型采用复制-生成双分支解码策略,在前端OCR结果置信度较高的情况下直接复制OCR结果,在OCR结果置信度较低的情况下生成新的预测结果,以此缓解前端OCR模型引入的识别错误。

此外,团队还基于OCR结果提取句子级的GraphDoc特征作为要素抽取模型输入,该特征融合了图像、文本、位置、版面多模态特征,相比于单模态的纯文本输入具有更强的特征表示。

在此基础上,团队还结合了UniLM、LiLT、DocPrompt多个要素抽取模型在不同场景、不同语种上的性能优势进一步提升了最终的要素抽取效果。