全国人机语音通讯会议是国内语音领域广大专家、学者和科研工作者交流最新研究成果,促进该领域研究和开发工作不断进步的重要舞台。该系列会议自1990年开创以来已成功召开了十七届。2023年第十八届全国人机语音通讯学术会议(National Conference on Man-Machine Speech Communication,NCMMSC2023)于 2023年12月8-10日在江苏苏州CCF业务总部&学术交流中心举行。

本次会议共评选出3篇最佳论文(投稿总数207篇),其中中国科学技术大学语音及语言信息处理国家工程研究中心智能语音信息处理团队的论文“APNet2: High-quality and High-efficiency Neural Vocoder with Direct Prediction of Amplitude and Phase Spectra”荣获最佳论文奖。论文第一作者为杜荟鹏博士研究生,论文通讯作者为艾杨特任副研究员。

图1 获奖证书

图2 最佳论文颁奖仪式,右二为杜荟鹏

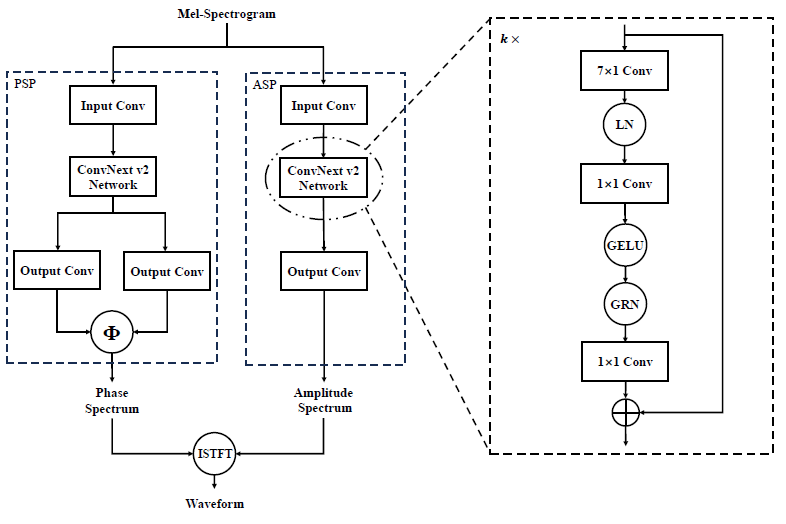

论文简介:在以前的工作中,我们提出了一个神经网络声码器APNet,可以实现从输入的声学特征中直接平行地预测5毫秒帧移的幅度谱和相位谱,最后通过逆短时傅里叶变换重构16kHz采样率的语音波形。APNet声码器的合成语音质量与HiFi-GAN声码器相当,但生成效率显著提升。然而,APNet声码器的性能仍然受波形采样率和谱帧移的约束,限制了其在更高质量语音合成中的实用性。因此,本文提出了APNet声码器的改进版本,命名为APNet2声码器。提出的APNet2声码器采用ConVNeXt v2网络作为幅度和相位预测的主干网络,以提升模型的建模能力。除此之外,APNet2声码器还将多分辨率判决器引入基于生成对抗网络的损失函数中,同时优化了一些损失函数的形式。在波形采样率为22.05kHz,谱帧移为256个样本点(约11.6毫秒)的通用实验配置下,本文提出的APNet2声码器在合成语音质量方面显著好于APNet声码器和Vocos声码器。相比于HiFi-GAN声码器和iSTFTNet声码器,本文提出的APNet2声码器在保证合成语音质量的情况下,生成速度明显更快。

图3 APNet2模型框图

论文资源:论文预印版网址:https://arxiv.org/pdf/2311.11545.pdf

语音样例网址:https://redmist328.github.io/APNet2_demo/

开源代码网址:https://github.com/redmist328/APNet2